چرا Google SGE در آزمایشگاه های گوگل گیر کرده است و چه اتفاقی می افتد؟

Google Search Generative Experience (SGE) قرار بود به عنوان یک آزمایش Google Labs در پایان سال 2023 منقضی شود، اما زمان آن به عنوان یک آزمایش بی سر و صدا تمدید شد و روشن کرد که SGE در آینده نزدیک برای جستجو نمی آید. با کمال تعجب، اجازه دادن به مایکروسافت ممکن است بهترین رویکرد ناخواسته برای گوگل بوده باشد.

استراتژی هوش مصنوعی گوگل برای جستجو

تصمیم گوگل برای حفظ SGE به عنوان یک پروژه Google Labs با روند گستردهتر تاریخ گوگل در ترجیح ادغام هوش مصنوعی در پسزمینه مطابقت دارد.

حضور هوش مصنوعی همیشه آشکار نیست، اما برای مدت طولانیتر از آنچه که اکثر مردم تصور میکنند، بخشی از جستجوی گوگل در پسزمینه بوده است.

اولین استفاده از هوش مصنوعی در جستجو به عنوان بخشی از الگوریتم رتبه بندی گوگل، سیستمی به نام RankBrain بود. RankBrain به الگوریتمهای رتبهبندی کمک کرد تا بفهمند چگونه کلمات در جستارهای جستجو با مفاهیم در دنیای واقعی مرتبط هستند.

به گفته گوگل:

هنگامی که RankBrain را در سال 2015 راه اندازی کردیم، این اولین سیستم یادگیری عمیق بود که در جستجو مستقر شد. در آن زمان، پیشگام بود… RankBrain (همانطور که از نامش پیداست) برای کمک به رتبه بندی – یا تصمیم گیری بهترین ترتیب برای – نتایج جستجو استفاده می شود.

پیادهسازی بعدی Neural Matching بود که به الگوریتمهای Google در درک مفاهیم گستردهتر در جستجوها و صفحات وب کمک کرد.

و یکی از شناخته شده ترین سیستم های هوش مصنوعی که گوگل راه اندازی کرده است، Multitask Unified Model است که با نام Google MUM نیز شناخته می شود. MUM یک سیستم هوش مصنوعی چندوجهی است که درک تصاویر و متن را در بر می گیرد و قادر است آن ها را در چارچوب هایی که در یک جمله یا یک عبارت جستجو نوشته شده است قرار دهد.

SpamBrain، هوش مصنوعی مبارزه با هرزنامه گوگل به احتمال زیاد یکی از مهم ترین پیاده سازی های هوش مصنوعی به عنوان بخشی از الگوریتم جستجوی گوگل است، زیرا به حذف سایت های با کیفیت پایین کمک می کند.

همه اینها نمونه هایی از رویکرد گوگل برای استفاده از هوش مصنوعی در پس زمینه برای حل مشکلات مختلف در جستجو به عنوان بخشی از الگوریتم هسته بزرگتر است.

این احتمال وجود دارد که گوگل به استفاده از هوش مصنوعی در پسزمینه ادامه میداد تا زمانی که مدلهای زبان بزرگ مبتنی بر ترانسفورماتور (LLM) بتوانند در پیشزمینه قدم بگذارند.

اما ادغام ChatGPT توسط مایکروسافت در بینگ، گوگل را مجبور کرد تا اقداماتی را برای افزودن هوش مصنوعی به روشی پیشزمینهتر با تجربه مولد جستجو (SGE) انجام دهد.

چرا SGE را در Google Labs نگه دارید؟

با توجه به اینکه مایکروسافت ChatGPT را در بینگ ادغام کرده است، ممکن است عجیب به نظر برسد که گوگل اقدام مشابهی انجام نداده است و در عوض SGE را در آزمایشگاه های گوگل نگه می دارد. دلایل خوبی برای رویکرد گوگل وجود دارد.

یکی از اصول راهنمای گوگل برای استفاده از هوش مصنوعی این است که تنها زمانی از آن استفاده کنید که موفقیت این فناوری ثابت شود و به گونه ای پیاده سازی شود که بتوان به مسئولیت پذیری آن اعتماد کرد و اینها دو موردی هستند که امروزه هوش مصنوعی مولد قادر به انجام آنها نیست.

حداقل سه مشکل بزرگ وجود دارد که باید قبل از اینکه هوش مصنوعی با موفقیت در پیش زمینه جستجو ادغام شود، حل شود:

- از LLM ها نمی توان به عنوان یک سیستم بازیابی اطلاعات استفاده کرد زیرا برای افزودن داده های جدید نیاز به آموزش کامل دارد. .

- معماری ترانسفورماتور ناکارآمد و پرهزینه است.

- هوش مصنوعی مولد تمایل به ایجاد حقایق اشتباه دارد، پدیده ای که به عنوان توهم شناخته می شود.

چرا هوش مصنوعی نمی تواند به عنوان موتور جستجو استفاده شود؟

یکی از مهمترین مشکلاتی که باید قبل از استفاده از هوش مصنوعی بهعنوان پشتیبان و پیشانی موتور جستجو حل شود، این است که LLMها نمیتوانند بهعنوان یک فهرست جستجو که در آن دادههای جدید به طور مداوم اضافه میشوند، عمل کنند.

به عبارت ساده، آنچه اتفاق میافتد این است که در یک موتور جستجوی معمولی، افزودن صفحات وب جدید فرآیندی است که در آن موتور جستجو معنای معنایی کلمات و عبارات درون متن را محاسبه میکند (فرآیندی به نام «جاسازی»)، که آنها را قابل جستجو و جستجو میکند. آماده ادغام در شاخص

پس از آن موتور جستجو باید کل فهرست را به روز کند تا بفهمد (به اصطلاح) کجا صفحات وب جدید در فهرست کلی جستجو قرار می گیرند.

افزودن صفحات وب جدید می تواند نحوه درک و ارتباط موتور جستجو با تمام صفحات وب دیگری را که در مورد آنها می داند تغییر دهد، بنابراین تمام صفحات وب را در فهرست خود مرور می کند و در صورت لزوم روابط آنها را با یکدیگر به روز می کند. این یک سادهسازی برای ارتباط مفهوم کلی از معنای افزودن صفحات وب جدید به فهرست جستجو است.

برخلاف فناوری جستجوی فعلی، LLMها نمیتوانند صفحات وب جدیدی را به فهرست اضافه کنند زیرا عمل افزودن دادههای جدید مستلزم بازآموزی کامل کل LLM است.

گوگل در حال تحقیق در مورد چگونگی حل این مشکل برای ایجاد یک موتور جستجوی LLM مبتنی بر ترانسفورماتور است، اما مشکل حل نشده است، حتی نزدیک نیست.

برای درک اینکه چرا این اتفاق میافتد، نگاهی گذرا به مقاله تحقیقاتی اخیر گوگل که توسط مارک نایورک و دونالد متزلر (و چندین نویسنده دیگر) با هم نویسندگی شده است، مفید است. من نام آنها را ذکر می کنم زیرا هر دوی این محققین تقریباً همیشه با برخی از مهم ترین تحقیقاتی که از گوگل منتشر می شود مرتبط هستند. بنابراین اگر نام هر یک از آنها روی آن باشد، احتمالاً تحقیق بسیار مهم است.

در توضیح زیر از فهرست جستجو به عنوان حافظه یاد می شود زیرا فهرست جستجو حافظه ای است از آنچه نمایه شده است.

عنوان مقاله: “DSI++: به روز رسانی حافظه ترانسفورماتور با اسناد جدید” (PDF)

استفاده از LLM به عنوان موتورهای جستجو فرآیندی است که از فناوری به نام شاخص های جستجوی متمایز (DSIs) استفاده می کند. فناوری فهرست جستجوی فعلی به عنوان رمزگذار دوگانه ارجاع داده می شود.

مقاله پژوهشی توضیح می دهد:

ساخت شاخص با استفاده از DSI شامل آموزش یک مدل ترانسفورماتور است. بنابراین، هر بار که بدنه اصلی بهروزرسانی میشود، مدل باید از ابتدا مجدداً آموزش داده شود، بنابراین هزینههای محاسباتی بسیار بالایی در مقایسه با رمزگذارهای دوگانه متحمل میشود.

این مقاله در ادامه راههایی را برای حل مشکل LLMهایی که «فراموش میکنند» را بررسی میکند، اما در پایان مطالعه آنها بیان میکنند که آنها فقط به سمت درک بهتر آنچه که باید در تحقیقات آینده حل شود پیشرفت کردهاند.

نتیجه می گیرند:

“در این مطالعه، ما پدیده فراموشی را در رابطه با افزودن اسناد جدید و متمایز به نمایه ساز بررسی می کنیم. توجه به این نکته مهم است که وقتی یک سند جدید سندی که قبلاً نمایه شده است را رد یا اصلاح می کند، رفتار مدل غیرقابل پیش بینی می شود و نیاز به تحلیل بیشتری دارد.

علاوه بر این، ما اثربخشی روش پیشنهادی خود را بر روی یک مجموعه داده بزرگتر، مانند مجموعه داده کامل MS MARCO بررسی میکنیم. با این حال، شایان ذکر است که با این مجموعه داده بزرگتر، روش فراموشی قابل توجهی را نشان می دهد. در نتیجه، تحقیقات بیشتری برای بهبود عملکرد مدل ضروری است، بهویژه زمانی که با مجموعه دادههایی در مقیاس بزرگتر سروکار داریم.»

LLM ها نمی توانند خودشان را بررسی کنند

گوگل و بسیاری دیگر نیز در حال تحقیق در مورد روشهای متعددی هستند تا بتوانند خود را از طریق هوش مصنوعی بررسی کنند تا از ارائه اطلاعات نادرست (که توهم نامیده میشود) جلوگیری کنند. اما تاکنون این تحقیقات پیشرفت چشمگیری نداشته است.

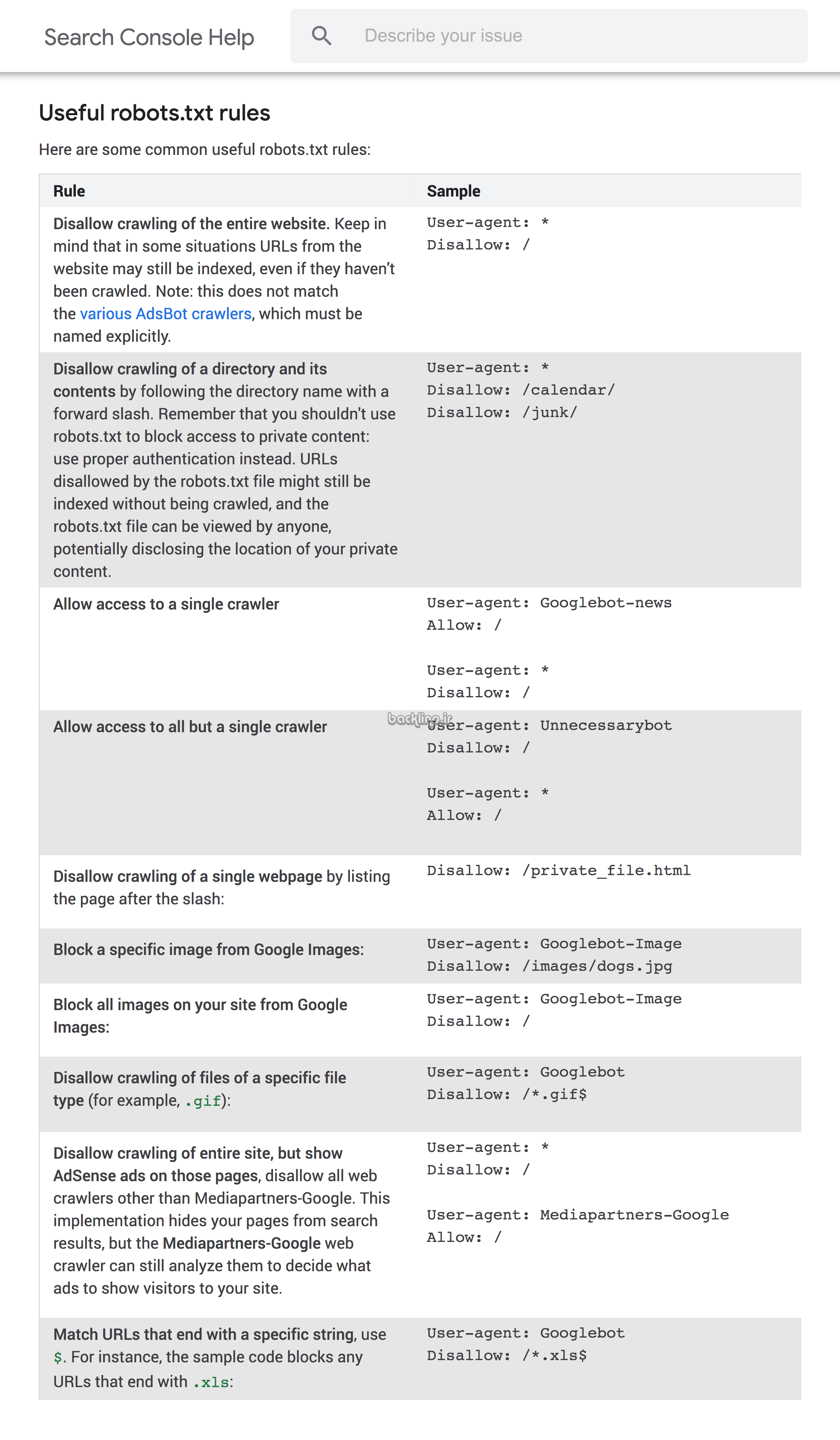

تجربه بینگ از هوش مصنوعی در پیش زمینه

بینگ مسیر متفاوتی را با گنجاندن هوش مصنوعی مستقیماً در رابط جستجوی خود در یک رویکرد ترکیبی در پیش گرفت که به یک موتور جستجوی سنتی با پیشانی هوش مصنوعی پیوست. این نوع جدید از موتورهای جستجو، تجربه جستجو را بهبود بخشید و بینگ را در رقابت برای کاربران موتورهای جستجو متمایز کرد.

ادغام هوش مصنوعی بینگ در ابتدا سر و صدای قابل توجهی ایجاد کرد و کاربران را مجذوب جدید بودن رابط جستجوی مبتنی بر هوش مصنوعی کرد. این منجر به افزایش تعامل کاربران بینگ شد.

اما پس از نزدیک به یک سال پرهیاهو، سهم بازار بینگ تنها با افزایش جزئی مواجه شد. گزارشهای اخیر، از جمله یکی از Boston Globe، حاکی از رشد کمتر از ۱ درصدی سهم بازار از زمان معرفی بینگ چت است.

استراتژی گوگل در آینده تایید شده است

تجربه بینگ نشان می دهد که هوش مصنوعی در پیش زمینه یک موتور جستجو ممکن است آنطور که انتظار می رفت موثر نباشد. افزایش اندک در سهم بازار سوالاتی را در مورد دوام طولانی مدت یک موتور جستجوی مبتنی بر چت ایجاد می کند و رویکرد احتیاطی Google در استفاده از هوش مصنوعی در پس زمینه را تأیید می کند.

تمرکز گوگل بر هوش مصنوعی در پسزمینه جستجو، با توجه به شکست بینگ در وادار کردن کاربران به کنار گذاشتن گوگل برای بینگ، اثبات میشود.

استراتژی حفظ هوش مصنوعی در پسزمینه، جایی که در این نقطه از زمان بهترین عملکرد را دارد، به Google اجازه داد تا کاربران را حفظ کند در حالی که فناوری جستجوی هوش مصنوعی در آزمایشگاههای Google در جایی که متعلق به آن است بالغ میشود.

رویکرد بینگ در استفاده از هوش مصنوعی در پیشزمینه اکنون تقریباً به عنوان یک داستان هشداردهنده در مورد مشکلات ناشی از عجله کردن یک فناوری قبل از درک کامل مزایای آن عمل میکند و بینشی در مورد محدودیتهای آن رویکرد ارائه میدهد.

از قضا، مایکروسافت در حال یافتن راه های بهتری برای ادغام هوش مصنوعی به عنوان یک فناوری پس زمینه در قالب ویژگی های مفیدی است که به محصولات اداری مبتنی بر ابر خود اضافه شده است.

آینده هوش مصنوعی در جستجو

وضعیت فعلی فناوری هوش مصنوعی نشان میدهد که بهعنوان ابزاری که از عملکردهای یک موتور جستجو پشتیبانی میکند، به جای اینکه بهعنوان کل قسمتهای پشتی و جلویی یک موتور جستجو یا حتی بهعنوان یک رویکرد ترکیبی که کاربران از اتخاذ آن خودداری کردهاند، مؤثرتر باشد.

استراتژی Google برای انتشار فناوریهای جدید تنها زمانی که کاملاً آزمایش شده باشند، توضیح میدهد که چرا جستجوی مولد به آزمایشگاههای Google تعلق دارد.

مطمئناً هوش مصنوعی نقش جسورانهتری در جستجو خواهد داشت، اما آن روز قطعا امروز نیست. انتظار می رود که گوگل ویژگی های مبتنی بر هوش مصنوعی بیشتری را به محصولات بیشتری اضافه کند و شاید تعجب آور نباشد که مایکروسافت در این مسیر ادامه دهد.

لینک کوتاه مقاله : https://5ia.ir/unztKx

کوتاه کننده لینک

کد QR :